原创文章,转载请注明: 转载自慢慢的回味

本文链接地址: Apollo无人驾驶

深入研究Apollo的代码是学习自动驾驶的很好途径。很多前沿科技,比如图像识别,激光雷达,多传感器融合,路径规划都可以直接完整的学习。

第一部分 感知模块Perception

感知模块输入来源于汽车物理感知设备,主要包含激光雷达,摄像头,毫米波雷达等。通过深度学习网络做实时检测障碍物(3D obstacles perception),进行障碍物分类,跟踪,识别周围环境如树木,人,其他交通参与者,交通灯等信息,为后续路径规划,控制等做辅助。通过高精地图,定位模块提供的位置,启动路口交通信号灯检测。

| 使用VSCode 调试Apollo无人车代码 | 深入研究Apollo的代码是学习自动驾驶的很好途径。很多前沿科技,比如图像识别,激光雷达,多传感器融合,路径规划都可以直接完整的学习。能够直接调试代码是比读代码更能加深理解。 |

| Apollo无人车的消息流转 | Apollo由无数的组件构成,每个组件独立运行,通过消息来进行相互依赖。每个组件构建在Cyber RT框架上,处理一组输入并产生其输出数椐。Launch 文件提供组件入口,DAG 文件配置组件依赖的消息输入等。 |

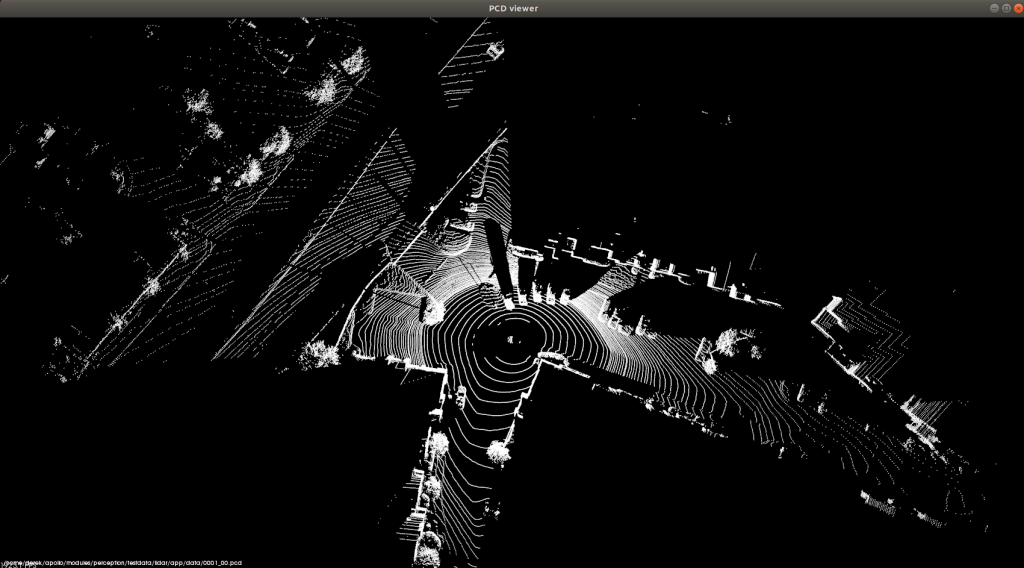

| Apollo自动驾驶的点云CNN分割 | 这儿以单元测试cnn_segmentation_test.cc的测试cnn_segmentation_sequence_test为例来分析Apollo自动驾驶的点云CNN分割。 |

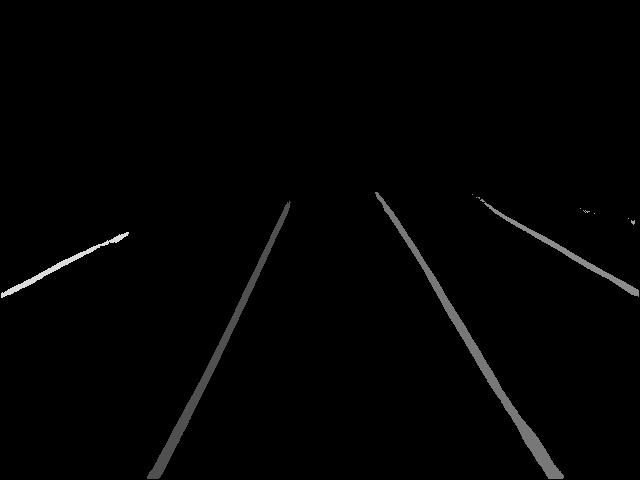

| Apollo自动驾驶车道检测 | 本篇以单元测试camera_lib_lane_postprocessor_darkscnn_lane_postprocessor_test.cc的测试camera_lane_postprocessor_point_test为例来分析Apollo自动驾驶怎么进行车道检测。 利用DarkSCNN算法对摄像头拍摄到的路面图片进行预测,来获取车道线在以车辆坐标系下的位置。 |

| Apollo自动驾驶Yolo障碍物检测 | 本篇以单元测试camera_lib_obstacle_detector_yolo_yolo_obstacle_detector_test.cc的测试demo_test为例来分析Apollo自动驾驶怎么使用Yolo算法来进行障碍物检测。 单元测试的Yolo算法基于Yolo V3改进,是单尺度检测的。 |

第二部分 规划模块Planning

规划模块为自动驾驶车辆规划时空轨迹。输出安全合理的运动轨迹信息,供控制模块执行。

| Cartesian与Frenet坐标系转换公式推导 | 车在道路上行驶,以车的视角来看,车就如同在一条光滑的曲线上移动,且不时带有左右偏移。为了算法简单,我们选择了Frenet坐标系,它可以把直角坐标系下的复杂轨迹转换为只有S,L两个维度的简单曲线。 |

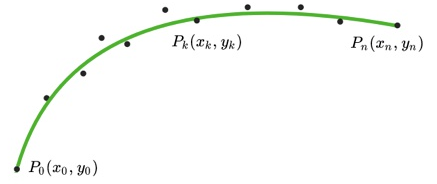

| Apollo参考线优化之DiscretePointsReferenceLineSmoother | Apollo的的规划算法基于Frenet坐标系,因此道路中心线的平滑性控制着车辆是否左右频繁晃动,而高精地图的道路中心线往往不够规划。Apollo在/modules/planning/reference_line中包含了多种参考线平滑算法:DiscretePointsReferenceLineSmoother(离散点平滑法,包括FEM_POS_DEVIATION_SMOOTHING有限元位置差异和COS_THETA_SMOOTHING余弦),QpSplineReferenceLineSmoother(三次样条插值法),SpiralReferenceLineSmoother(螺旋曲线法)。本篇以单元测试discrete_points_reference_line_smoother_test.cc的测试TEST_F(DiscretePointsReferenceLineSmootherTest, smooth)为例来分析Apollo对参考线reference line进行离散点平滑(FEM_POS_DEVIATION_SMOOTHING)的原理。 |

| Apollo二次规划算法(piecewise jerk path optimizer)解析 | Apollo里面最重要的模块就是感知和规划模块,规划模块最重要的是路径规划和速度规划任务,对应ROS机器人里面的局部规划。Apollo的规划模块首先根据当前的情况进行多场景(scenario)调度,每个场景又包含一个或者多个阶段(stage),每个阶段又由多个具有独立功能的小模块任务(task)完成。这篇文章就主要解读一下路径规划piecewise jerk path optimizer这个任务。任务最终会生成轨迹(trajectory):每个点的位姿和速度信息,进而输出给控制模块去控制车辆。 |

| Apollo二次规划算法(piecewise jerk speed optimizer)解析 | Apollo里面最重要的模块就是感知和规划模块,规划模块最重要的是路径规划和速度规划任务,对应ROS机器人里面的局部规划。Apollo的规划模块首先根据当前的情况进行多场景(scenario)调度,每个场景又包含一个或者多个阶段(stage),每个阶段又由多个具有独立功能的小模块任务(task)完成。前面介绍了路径规划piecewise jerk speed optimizer这个任务,这篇文章就解读一下速度规划piecewise jerk speed optimizer这个任务。SL规划保证车辆的横向偏移足够平滑,ST规划保证车辆的前进方向速度变化足够平滑。 |

本作品采用知识共享署名 4.0 国际许可协议进行许可。

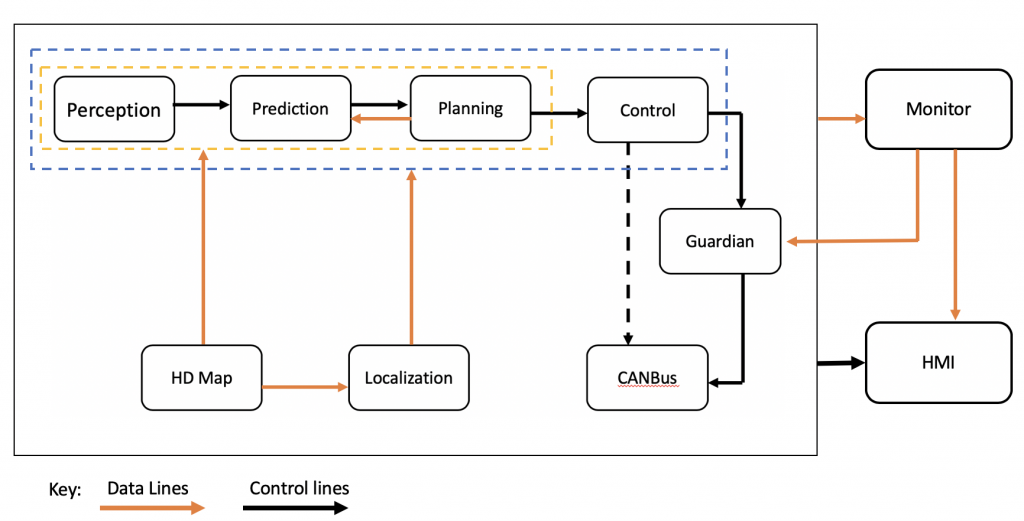

Apollo架构图

Apollo架构图

![Rendered by QuickLaTeX.com \[ cost_{smooth}=\sum_{k=0}^{n-3}\parallel (x_k+x_{k+2})-2x_{k+1} \parallel^2_2 \]](https://liuxiaofei.com.cn/blog/wp-content/ql-cache/quicklatex.com-f64b22c128dd928b1369191984776b2f_l3.png)

![Rendered by QuickLaTeX.com \[ cost_{length}=\sum_{k=0}^{n-2}\parallel y_{k+1}-y_k \parallel^2_2 \]](https://liuxiaofei.com.cn/blog/wp-content/ql-cache/quicklatex.com-8a4d80eb5930b977bb9c265eddbd6988_l3.png)

![Rendered by QuickLaTeX.com \[ cost_{deviation}=\sum_{k=0}^{n-1}\parallel z_k-z_{k-ref} \parallel^2_2 \]](https://liuxiaofei.com.cn/blog/wp-content/ql-cache/quicklatex.com-e5f862bb92e076646dca64ebeb3f6a8d_l3.png)

摄像头输出图片

摄像头输出图片 DarkSCNN输出的车道线Mask图

DarkSCNN输出的车道线Mask图 融合到原图上的车道线

融合到原图上的车道线 测试用例PCD文件可视化结果

测试用例PCD文件可视化结果